NSDT工具推荐: Three.js AI纹理开发包 - YOLO合成数据生成器 - GLTF/GLB在线编辑 - 3D模型格式在线转换 - 可编程3D场景编辑器 - REVIT导出3D模型插件 - 3D模型语义搜索引擎 - Three.js虚拟轴心开发包 - 3D模型在线减面 - STL模型在线切割

想象一下,作为一名视频游戏设计师,你希望在游戏中使用 3D 龙模型。 以前,你可以通过两种方式执行此操作:

- 自己制作复杂的 3D 模型或从多个角度拍摄龙模型的照片。

- 前往 3D 模型存储库寻找龙,但随后你必须使用关键字进行搜索,并希望上传者已将其放入其描述中。

如果你愿意查看数百甚至数千条 3D 龙,这很好。 但如果你想要一种特定的龙呢? 亚洲风格的龙而不是西方风格的龙? 有点像蛇吗? 或者更像恐龙? 你可能会花费数小时寻找与你的想法相匹配的内容。

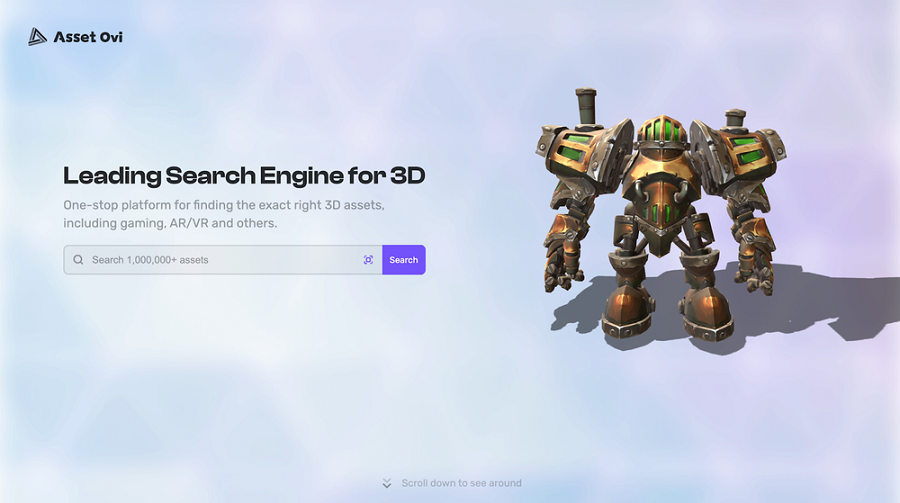

现在,通过使用基于神经搜索的 3D 模型存储库 Asset Ovi,你只需上传 3D 模型即可搜索相似模型,或者单击现有模型来查找其他类似模型。

尽管游戏设计师对 3D 模型的需求快速增长,但还没有成熟的解决方案来查找存储在存储库中的 3D 资产。 大多数搜索引擎都是基于文本的:它们只能将文本查询与文本描述和关键字列表相匹配。 人们说一张图片抵得上一千个文字,因此 3D 模型至少也值一千个文字。 关键字列表和文本描述很少超过一两句话。 他们永远无法捕获与搜索相关的模型的所有信息。

即使是最有经验的用户也可以轻松地花费数小时在资产存储库中寻找,却找不到他们需要的东西,也不知道他们正在寻找的东西是否存在。

为了解决这个问题,我们在 Asset Ovi 中部署了神经搜索,使用 Jina AI 突破性的多模态信息检索框架将 3D 模型与其他 3D 模型进行比较,而不需要详细的描述或数千个关键字。

Asset Ovi 的神经搜索技术支持两种搜索方法:

- 上传模型搜索。 用户上传自己的3D模型,我们从中提取3D网格数据,然后使用Jina的神经搜索技术来识别相似的模型。 这种相似性不是基于总体形状和颜色,而是基于人工智能驱动的对网格正在建模的事物类型的识别。

- 根据 Asset Ovi 中已存储的模型进行搜索。 这与用户上传搜索的处理方式相同,只不过它从用户接收模型 ID 并使用与其匹配的已存储模型。

在集成 Jina 的神经搜索解决方案之前,我们花费了大量的时间和精力手动标记模型并为它们提供基于文本的搜索系统的描述。 Jina与我们合作,将其已经成熟的图像搜索技术扩展到3D模型。

最关键的挑战是开发高效的3D模型表示方法和相似度匹配算法,以确保任何3D模式的稳定表示和分类。

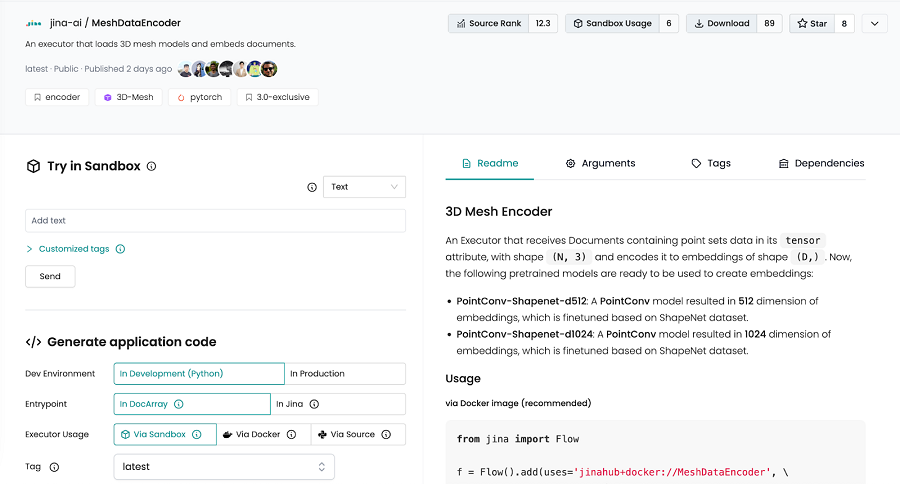

为此,Jina AI 的工程师团队开发了将 3D 模型编码为向量的技术,以实现高级理解。

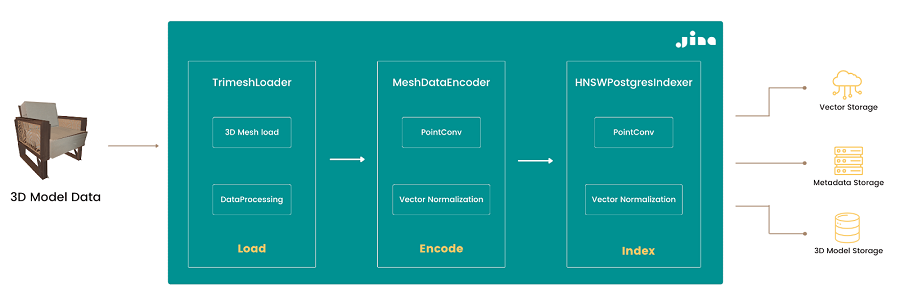

模型搜索的业务流程大致可以分为以下几个流程。

- 加载3D模型:加载3D模型(支持GLB、GLTF等格式),提取点云并进行预处理。

- 特征提取:为了从 3D 网格数据输出特征向量,我们使用 PointConv 模型。

- 相似度检索:将归一化的特征向量索引到 PostgreSQL 数据库中,并使用 HNSW 算法查找给定数据集中的高维向量相似度。

整个流程搭建完成后,我们就可以使用Jina提供的工具一键导出Kubernetes部署文件,然后直接部署到云服务或者集群上。

YAHAHA目前拥有数十万创作者用户。 为了让我们庞大的模型存储库的用户更容易找到他们想要的东西,我们做了以下努力。

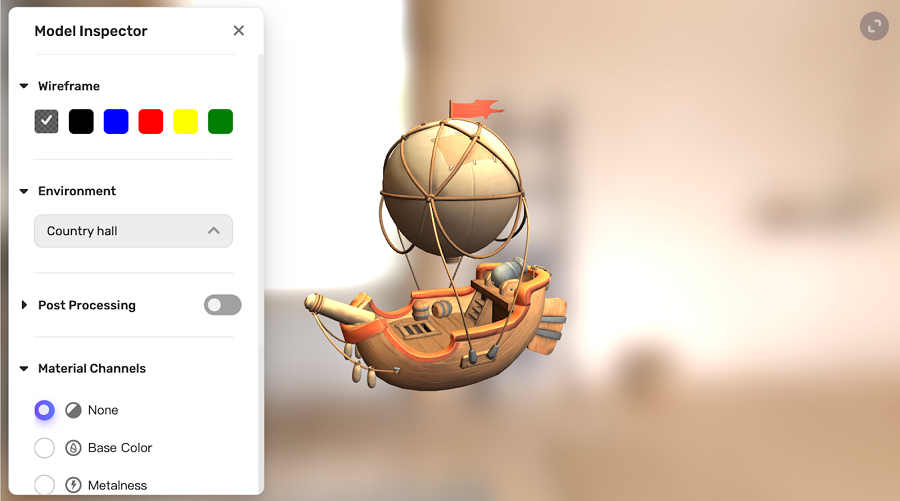

- 3D 直接预览:Unity Asset Store 和 CGTrader 等资源存储库以 2D 形式显示对象,因此很难看出它们将如何呈现为 3D 对象。 Asset Ovi 现在为用户提供真正的 3D 预览,通过将完整网格传输到查看者的浏览器,不会损害模型创建者的知识产权。

- 渲染效果:为了保证所见即所得,我们确保网站渲染与客户端渲染尽可能匹配,尤其是对于Unity。

- 神经搜索:我们已经为数百万个模型建立了索引。 感谢 Jina,我们不再需要手动标记所有模型。 我们的搜索以人工智能驱动的方式进行,不再需要关键字。

Neural Search为Asset Ovi用户提供了强大的搜索功能,大大提高了他们寻找合适模型的效率和用户体验。 未来,我们还将让 Asset Ovi 成为 Unity Asset Store 的附属计划,帮助 Unity 开发者在 Unity Asset Store 上高效找到制作游戏所需的相关素材。 我们还将与Sketchfab、CGTrader等资源网站合作,帮助所有用户、开发者、艺术家等更轻松地找到他们需要的资源。

原文链接:AI-Powered 3D Asset Management with Neural Search

BimAnt翻译整理,转载请标明出处